ReadPapers

SegMamba

通道注意力的本质是什么,mamba采用“并行扫描算法”而非“卷积”来进行模型的循环计算,其是否也考虑了通道维度上的内容,是否存在和原始的CNN一样对所有通道上的内容一视同仁的问题

摘要

摘要。Transformer 架构在建模全局关系方面表现出色。然而,它在处理高维医学图像时带来了巨大的计算挑战。Mamba 作为一种状态空间模型 (SSM),最近成为一种用于对序列数据中的长距离依赖关系进行建模的著名方法,凭借其出色的内存效率和计算速度在自然语言处理领域表现出色。受其成功的启发,我们推出了 SegMamba,一种新颖的 3D 医学图像分割 Mamba 模型,旨在有效捕获每个尺度的全体积特征内的长距离依赖关系。与基于 Transformer 的方法相比,我们的 SegMamba 在整个体积特征建模方面表现出色,即使体积特征的分辨率为 64 × 64 × 64(序列长度约为 260k),也能保持卓越的处理速度。在三个数据集上进行的综合实验证明了我们的 SegMamba 的有效性和效率。此外,为了促进 3D 结直肠癌 (CRC) 分割研究,我们贡献了一个新的大规模数据集(名为 CRC-500)。SegMamba 的代码和有关 CRC-500 数据集的信息可在以下位置找到:https://github.com/gexing/SegMamba

模型

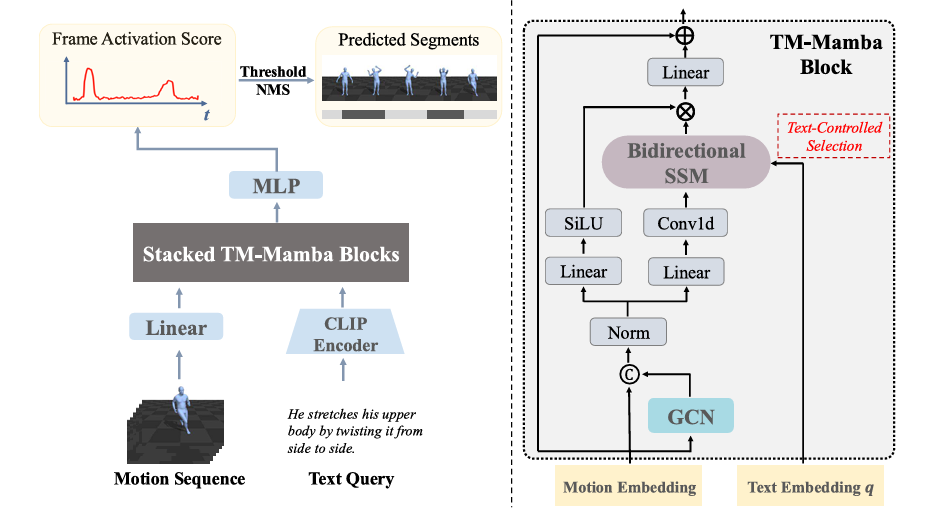

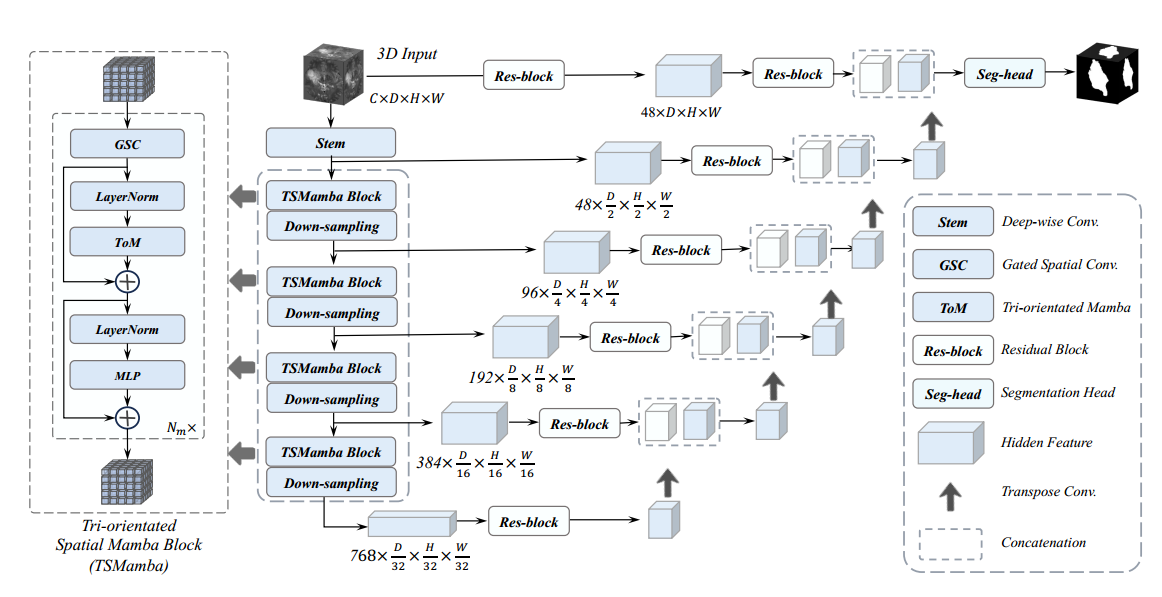

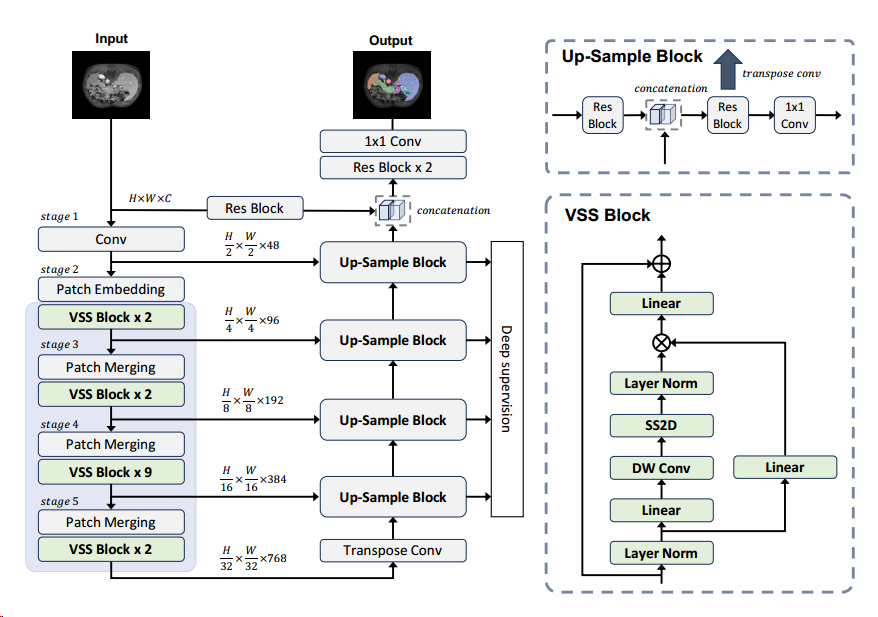

SegMamba 主要由三个组件组成:1)具有多个三向空间 Mamba 块的 3D 特征编码器,用于对不同尺度的全局信息进行建模;2)基于卷积层的 3D 解码器,用于预测分割结果;3)跳跃连接,用于将全局多尺度特征连接到解码器以实现特征重用。图 2 说明了所提出的 SegMamba 的概览。

对于 3D 医学图像分割而言,全局特征和多尺度特征建模至关重要。Transformer 架构可以提取全局信息,但在处理过长的特征序列时会产生很大的计算负担。为了减少序列长度,基于 Transformer 架构的方法(例如 UNETR)直接将分辨率为 D × H × W 的 3D 输入下采样为 D 16 × H 16 × W 16。然而,这种方法限制了编码多尺度特征的能力,而多尺度特征对于通过解码器预测分割结果至关重要。为了克服这个限制,我们设计了一个 TSMamba 模块,以实现多尺度和全局特征建模,同时在训练和推理期间保持高效率。

编码器由一个 stem 层和多个 TSMamba 块组成。stem 层提取第一个尺度特征 z0 ∈ R 48× D 2 × H 2 × W 2。 然后,z0 被输入到每个 TSMamba 块和相应的下采样层。

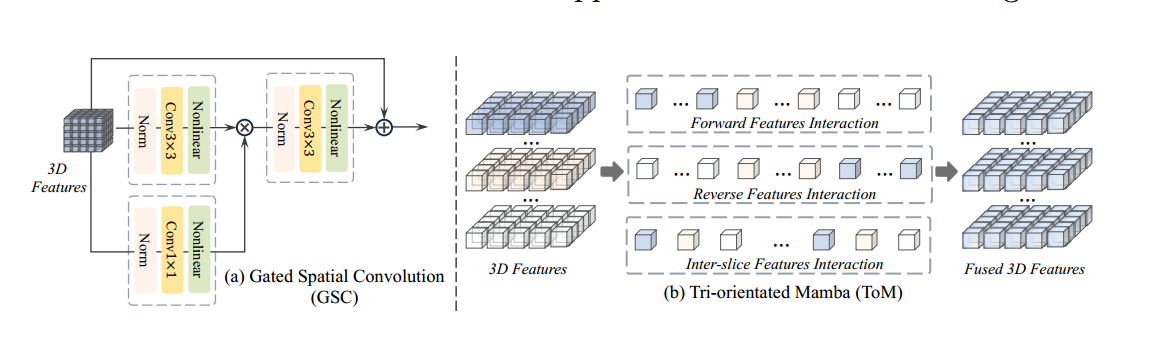

门控空间卷积 (GSC) Mamba 层通过将 3D 特征展平为 1D 序列来对特征依赖性进行建模。因此,为了在 Mamba 层之前提取空间关系,我们设计了一个门控空间卷积 (GSC) 模块。如图 3 (a) 所示,输入的 3D 特征被送入两个卷积块(一个卷积块包含一个范数、一个卷积和一个非线性层),卷积核大小分别为 3×3×3 和 1×1×1。

然后将这两个特征逐像素相乘,以类似于门机制 [13] 的信息传输进行控制。最后,使用卷积块进一步融合特征,同时利用残差连接重用输入特征。

三向 Mamba (ToM) 在 TSMamba 模块中,为了有效地对高维特征的全局信息进行建模,我们设计了一个三向 Mamba 模块,从三个方向计算特征依赖关系。如图 3 (b) 所示,我们将 3D 输入特征展平为三个序列,以执行相应的特征交互并获得融合的 3D 特征。

结论

提出了第一种基于 Mamba 的通用 3D 医学图像分割方法,称为 SegMamba。我们设计了一个三向 Mamba (ToM) 模块来增强 3D 特征的顺序建模。然后,为了有效地对空间特征进行建模,我们进一步设计了一个门控空间卷积 (GSC) 模块,以在每个 ToM 模块之前增强空间维度中的特征表示。

复现实验

经过一周的安装和配置环境,终于把这个代码给跑了起来,在这里再骂一遍python狗屎的各种版本。超!在看复现数据之前,先了解相关的评价指标

Dice系数

Dice系数是一种集合相似度度量函数,通常用于计算两个样本的相似度,取值范围在[0,1]

其中 |X∩Y| 是X和Y之间的交集,|X|和|Y|分表表示X和Y的元素的个数,其中,分子的系数为2,是因为分母存在重复计算X和Y之间的共同元素的原因

MIoU之前已经了解过了,对于二分类的任务来说,二者思想都是交集/并集,但dice并不是在分母上减去交集,而是将交集在分子上算了两次。

对于多分类来说,Dice是将预测结果转为了多通道,而MIoU只在一个通道上计算。

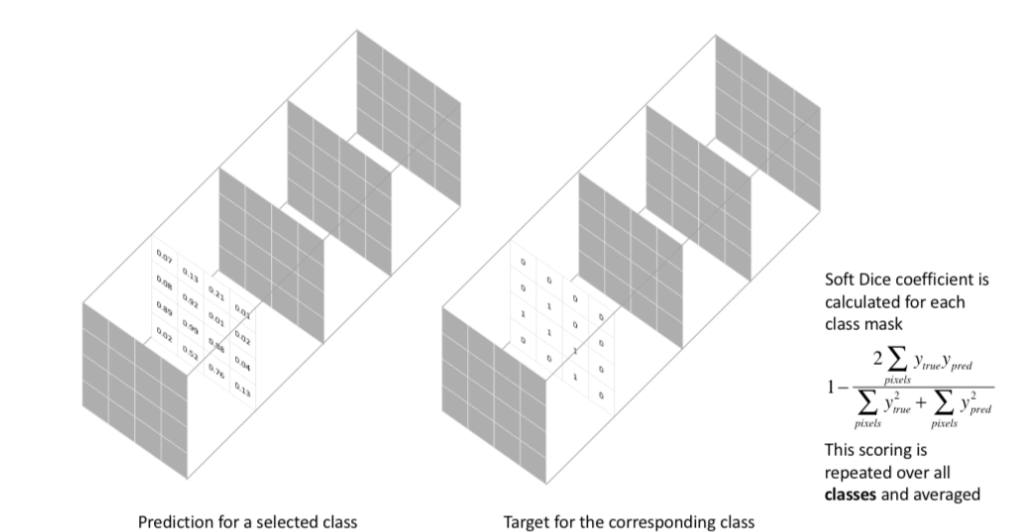

Dice Loss

这种损失函数被称为 **Soft Dice Loss,**因为我们直接使用预测概率而不是使用阈值或将它们转换为二进制mask。Soft Dice Loss 将每个类别分开考虑,然后平均得到最后结果

(1)训练误差曲线非常混乱,很难看出关于收敛的信息。尽管可以检查在验证集上的误差来避开此问题。

(2)Dice Loss比较适用于样本极度不均的情况,一般的情况下,使用 Dice Loss 会对反向传播造成不利的影响,容易使训练变得不稳定。

所以在一般情况下,还是使用交叉熵损失函数。

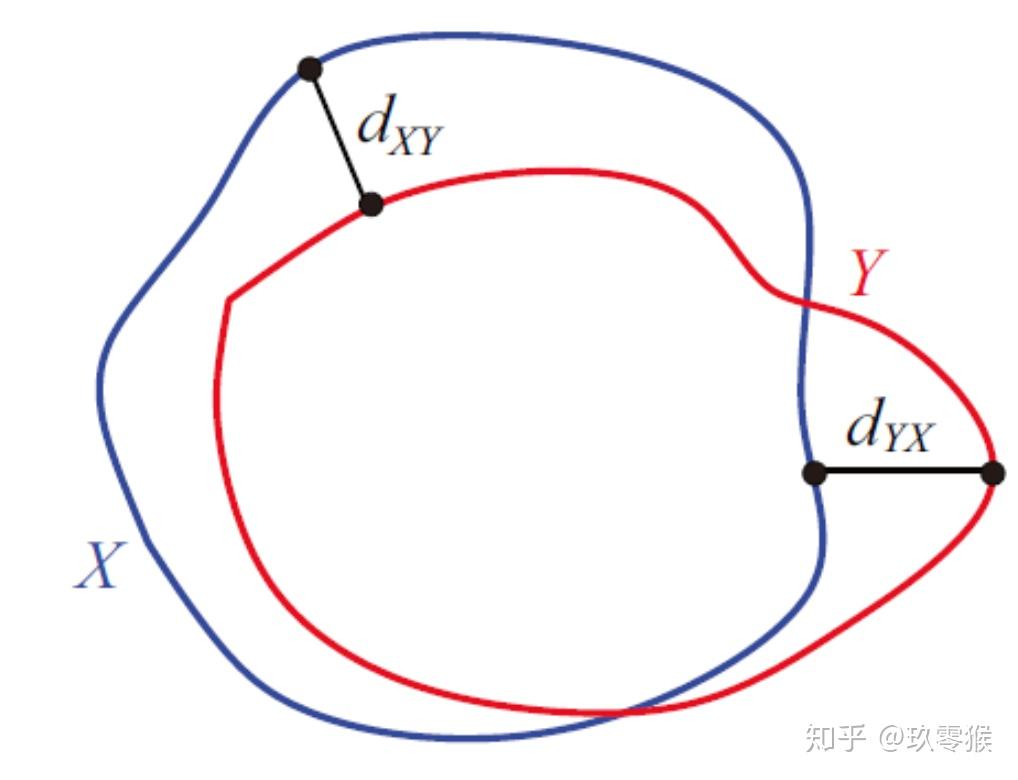

豪斯多夫距离(Hausdorff distance)

一般使用dice衡量区域的重合程度,使用95%的HD( Hausdorff Distance)去衡量边界的重合程度,之所以取95%,是因为要滤去5%的离群点。

Hausdorff distance是描述两组点集之间相似程度的一种量度,它是两个点集之间距离的一种定义形式:假设有两组集合A={a1,…,ap},B={b1,…,bq},则这两个点集合之间的Hausdorff distance定义为:

其中,

‖·‖是点集A和B点集间的距离范式。(如:L2或Euclidean距离).

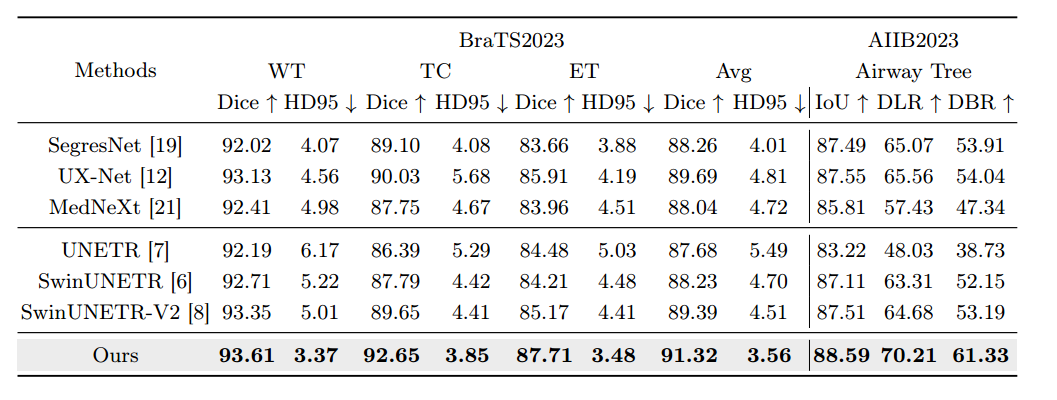

数据集

BraTS2023 数据集 共包含 1,251 个 3D 脑部 MRI 体积。每个体积包括四种模态(即 T1、T1Gd、T2、T2-FLAIR)和三个分割目标(TC:肿瘤核心、WT:整个肿瘤、ET:增强肿瘤)

这里复现使用的环境为pytroch 2.01,causal-conv1d 1.0.0 , mamba 1.2.0.post1 (site-page里面mamba-ssm换成了mamba 1.0.1)

1 | |

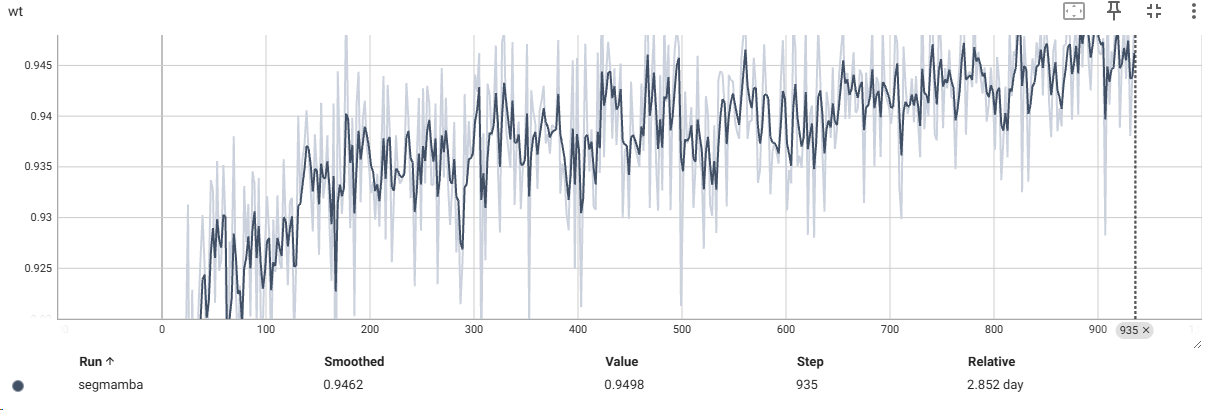

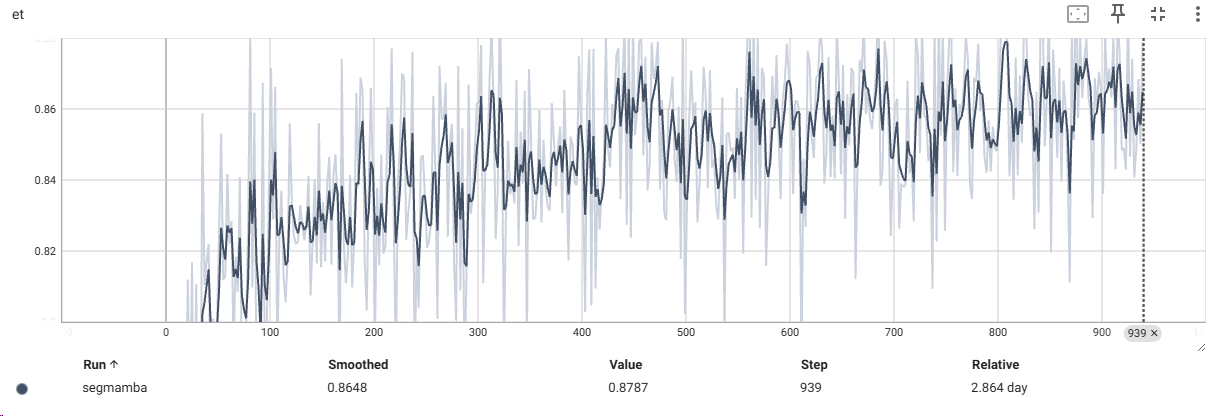

下表就是复现实验的部分Dice数据:

| Epoch | tc | wt | et | avg |

|---|---|---|---|---|

| 19 | 0.8111 | 0.8987 | 0.7715 | 0.8270 |

| 25 | 0.8550 | 0.9313 | 0.8168 | 0.8676 |

| 35 | 0.8839 | 0.9208 | 0.8588 | 0.8878 |

| … | … | … | … | … |

| 119 | 0.9089 | 0.9292 | 0.8559 | 0.8980 |

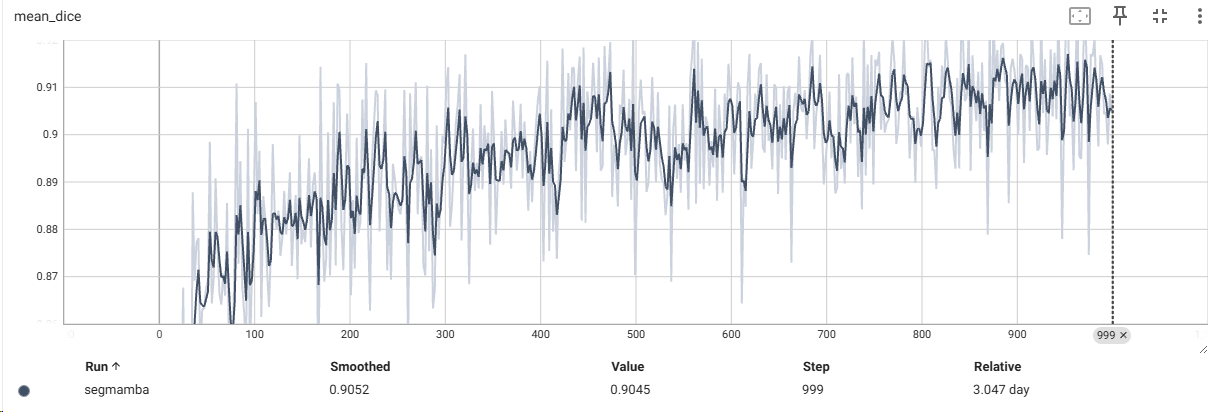

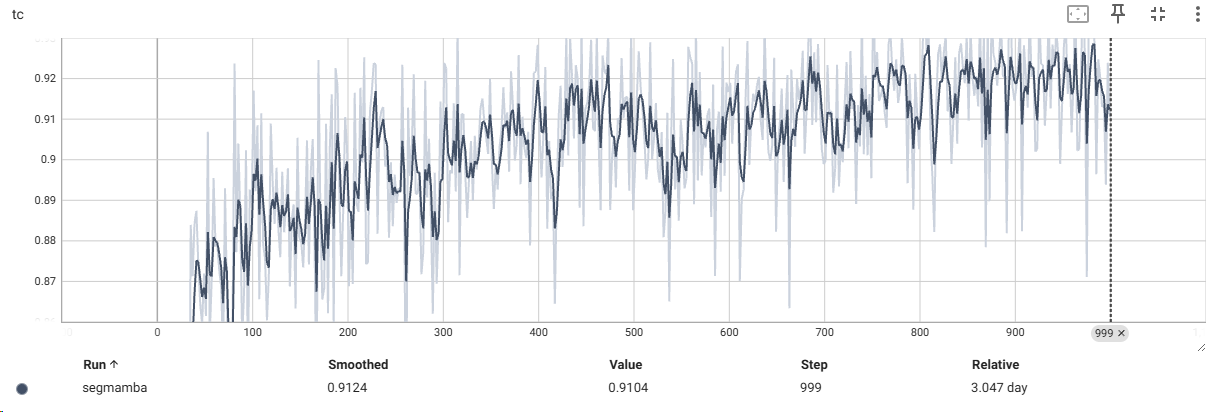

使用TensorBoard进行数据可视化

1 | |

SwinUMamba

摘要

摘要:准确的医学图像分割需要融合从局部特征到全局依赖的多尺度信息。然而,现有的方法对远程全局信息建模是具有挑战性的,其中卷积神经网络(CNN)受到其局部感受野的限制,视觉变换器(ViTs)受到其注意力机制的高二次复杂性的影响。最近,基于Mamba的模型以其在长序列建模方面的出色能力而受到广泛关注。一些研究表明,这些模型在各种任务中的性能优于流行的视觉模型,具有更高的精度,更低的内存消耗和更少的计算负担。然而,现有的基于Mamba的模型大多是从头开始训练,并且没有探索预训练的力量。本文介绍了一种新的Mambabased模型Swin-Umamba,它是专门为医学图像分割任务设计的,利用基于ImageNet的预训练的优势。我们的实验结果揭示了基于ImageNet的训练在提高Mamba性能方面的重要作用-SwinUAmba与CNN、ViT和最新的基于Mamba的模型相比,表现出上级性能。值得注意的是,在AbdomenMRI、Encoscopy和Microscopy数据集上,Swin-UAmamba比其最接近的对手U-Mamba_Enc的平均得分高出2.72%。Swin-UAmamba的代码和模型可在www.example.com上公开获得https://github.com/JiarunLiu/Swin-UMamba。

引言

在本文中,我们提出了一个基于Mamba的网络Swin-UMamba,用于2D医学图像分割。Swin-UMamba使用一个通用的编码器,将预训练的视觉模型的强大功能与一个精心设计的解码器集成在一起,用于医学图像分割任务。此外,我们提出了一个变体结构SwinUMamba†,带有一个基于Mamba的解码器,为高效应用提供更少的参数和更低的FLOP。我们的贡献可以总结如下:

模型

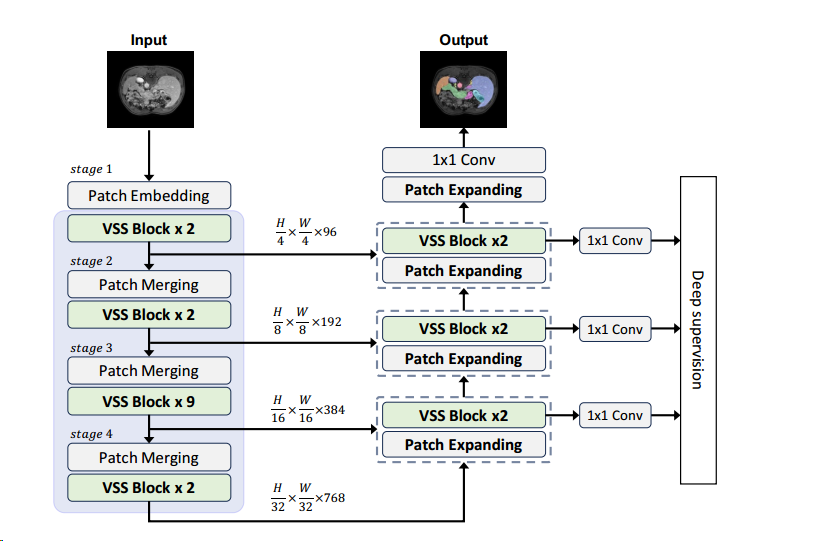

Swin-Umamba的三个核心部分分别是:1)数据集(即ImageNet),用于提取不同尺度的特征; 2)解码器,具有多个上采样块,用于预测分割结果; 3)跳过连接,用于弥合低级细节和高级语义之间的差距。我们将在下面的章节中介绍Swin-Umamba的详细结构。

VSS块

基于[24]的见解,我们将视觉状态空间(VSS)块作为Swin-UMAMBA中的基本单元。VSS块通过采用2D选择性扫描(SS 2D)来解决与2D图像数据相关的挑战。

Swin-Umamba的编码器可以分为5个阶段。第一阶段是茎阶段。它包含一个卷积层,用于2×下采样,具有7×7内核,填充大小为3,Swin-Umamba的第一阶段与VMamba不同,因为我们更喜欢一个逐渐向下的过程,采样过程,每个阶段进行2×下采样。该策略旨在保留低级别细节,这对医学图像分割很重要[8,32]。第二阶段使用2 × 2补丁大小的补丁嵌入层,将特征分辨率保持在原始图像的1/ 4×,这与VMamba中的嵌入特征相同。后续阶段遵循VMamba-Tiny的设计,其中每个阶段由用于2×下采样的补丁合并层和用于高级特征提取的多个VSS块组成。与ViT不同,由于VSS块的因果性质,我们没有采用Swin-Umamba中的位置嵌入[24]。

模型结构

阶段2到阶段5的VSS块的数量分别为{2,2,9,2}。每个阶段之后的特征维度相对于阶段二次增加,导致D = {48,96,192,384,768}。我们使用来自VMamba-Tiny的ImageNet预训练权重初始化VSS块和补丁合并层,如图1所示。值得注意的是,由于片大小和输入通道的差异,片嵌入块没有用预先训练的权重初始化。

我们遵循常用的U形结构,使用密集的跳跃连接来构建Swin-UAmamba。U-Net及其变体在医学图像分割任务中表现出了显着的效率。该架构利用跳跃连接来恢复低级别细节,并采用编码器-解码器结构来提取高级信息。为了增强U-Net中的原生上采样块,我们引入了两个修改:1)具有剩余连接的额外卷积块以处理跳过连接特征,以及2)每个尺度的额外分割头用于深度监督[33]。

SwinUMamba†

为了进一步探索Mamba在医学语义分割中的潜力,我们提出了一种基于Mamba解码器的Swin-Umamba变体,即SwinUMamba†。我们将证明SwinUMamba†可以获得与Swin-Umamba相比具有竞争力的结果,同时使用更少的网络参数和更低的计算负担,Swin-Umamba中源自输入图像和2×下采样特征的跳过连接被删除,因为没有对应于它们的解码块。此外,在1×、1/ 4×、1/ 8×和1/ 16×分辨率下应用了深度监控,并结合了额外的分割头(即,将高维特征映射到K的1 × 1卷积)。结合所有这些修改,网络参数的数量从60 M减少到28 M,在AbdomenMRI数据集上,FLOP从68.0G减少到18.9G。关于网络参数和FLOP数量的进一步统计数据见表1、表2和表3。SwinUMamba†的结构见图2。

结论

本研究旨在揭示基于ImageNet的预训练对Mambabased模型在二维医学图像分割中的影响。我们提出了一种新的Mambabased模型Swin-UAmamba及其变体SwinUMamba†,两者都能够利用预训练模型的分割任务的能力。我们在各种医学图像分割数据集上的实验表明,基于ImageNet的预训练对基于Mamba的模型有几个优点,包括上级分割精度、稳定的收敛性、过拟合问题的缓解、数据效率和较低的计算资源消耗。我们相信,我们的研究结果突出了预训练在增强基于Mamba的模型在视觉任务中的性能和效率方面的重要性。

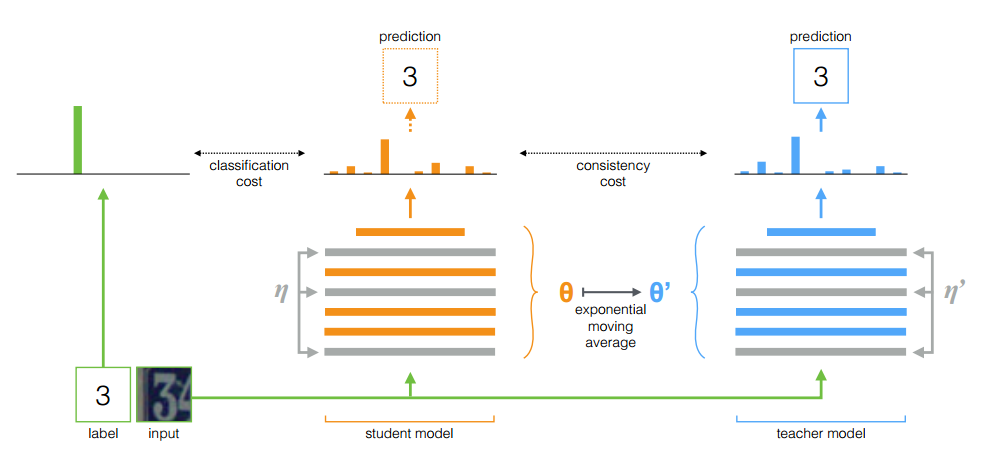

Mean teachers model

Tarvainen A, Valpola H. Mean teachers are better role models: Weight-averaged consistency targets improve semi-supervised deep learning results[J]. Advances in neural information processing systems, 2017, 30.

该算法中教师模型不同学生模型一样,并不是每个step都进行权重更新,而是将学生模型连续训练若干step后产生的权重平均值作为更新权重。教师模型使用学生模型的EMA权重,而不是与学生模型共享权重。论文中表示平均模型权重往往会产生一个比直接使用最终权重更精确的模型。它可以在每一个step完成后即刻聚合之前学习到的所有信息,而不仅仅在每一个epoch。此外,由于EMA提高了所有层的输出质量,而不仅仅是最后一层的输出,因此模型能够更好地表征中层乃至高层语义信息。这些方面造就了该模型相对于Temporal ensemble的两个优势。首先,更准确的标签使学生和教师模型之间发生更快的反馈循环,从而产生更好的精度。其次,这种方法适用于大型数据集和在线学习。

- 对数据进行两种不同的加噪。

- 将不同噪声增强后的两幅图像分别输入到学生模型的和教师模型。

- 对输出使用softmax激活,计算学生模型输出与教师模型输出的一致性损失函数, 如果原图像存在label,则还与label计算交叉熵信息损失。

- 用梯度下降法更新学生模型的权重,教师模型的权重用学生权重的指数移动平均法(EMA)更新(一部分权重来自历史的教师模型权重,另一部分来自于当前的学生模型的权重):

模型缺点:

- 教师模型的选择对模型性能至关重要。选择一个不合适的教师模型可能会导致性能下降。因此,需要进行一些实验来确定最佳的教师模型。

- Mean Teacher 模型仍然需要一些有标签的数据来进行监督训练,尤其是在初期阶段。这意味着它不适用于完全无监督的情况。

- Mean Teacher 假设有标签和无标签的数据是从相同的数据分布中生成的。如果这个假设不成立,模型性能可能会受到影响。

- Mean Teacher 模型对数据中的噪声和异常值比较敏感。这可能导致模型在存在异常数据的情况下性能下降。

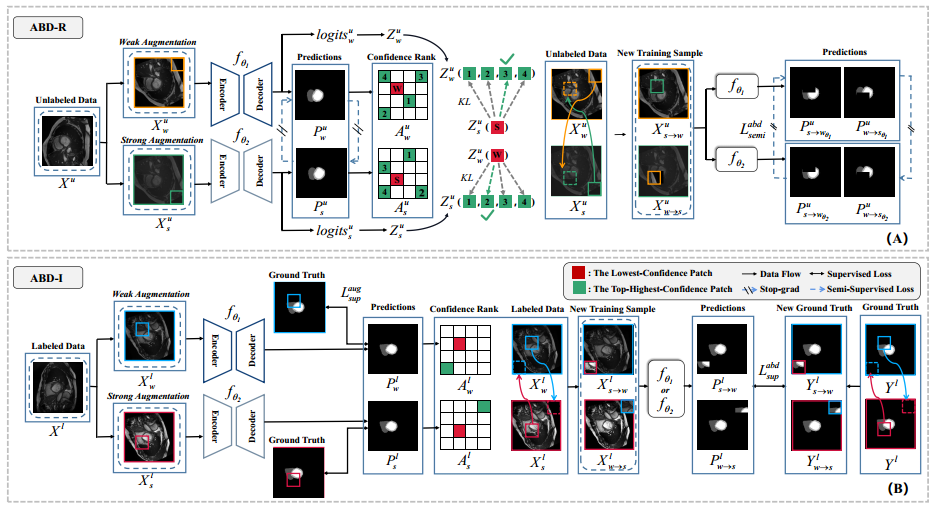

ABD半监督医学图像分割

Chi H, Pang J, Zhang B, et al. Adaptive Bidirectional Displacement for Semi-Supervised Medical Image Segmentation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2024: 4070-4080.

摘要

本文提出了一种自适应双向置换(ABD)方法,用于解决半监督医学图像分割(SSMIS)中的一致性学习挑战。该方法通过设计基于可靠预测置信度的双向补丁置换,生成新的样本,有效抑制了不可控区域,同时保留了输入扰动的影响。此外,为了增强模型对潜在不可控内容的学习能力,提出了针对标记图像的逆置信度双向置换操作,生成了包含更多不可靠信息的样本,以促进模型学习。实验表明,ABD方法在半监督医学图像分割任务中取得了新的最优性能,显著提升了不同基线方法的表现。

本文贡献:

作者设计了基于可靠预测置信度的双向补丁置换操作。这一创新点在于,它利用了模型对未标记数据的预测结果,根据置信度将图像划分为可靠和不可靠区域,并通过置换这些区域的补丁来生成新的训练样本。这种方法有效地抑制了不可控区域的影响,同时保留了输入扰动对模型训练的积极作用。

逆置信度置换策略: 针对标记数据,作者提出了逆置信度双向置换操作。这一策略通过在高置信度区域内选择相对不可靠的补丁,在低置信度区域内选择相对可靠的补丁进行置换,生成了包含更多不可靠信息的样本。这一创新点有助于模型学习如何更好地处理潜在的不可控内容,提高了模型的泛化能力。

**实验验证与性能提升:**作者在多个医学图像分割数据集上进行了实验验证,结果表明ABD方法显著提升了半监督医学图像分割的性能。通过与其他先进方法进行比较,ABD方法展现出了优越的性能表现,验证了其在实际应用中的有效性。

**消融实验与组件重要性分析:**为了深入探究ABD方法中各个组件的重要性,作者们进行了消融实验。通过移除基于可靠预测置信度的双向补丁置换和逆置信度双向置换操作,并观察模型性能的变化,作者们发现这两个组件都对ABD方法的性能提升起到了关键作用。这一分析进一步验证了ABD方法的创新性和有效性。

自适应双向置换(ABD)方法

为了应对半监督医学图像分割中的一致性学习挑战,研究者们提出了一种创新的自适应双向置换(ABD)方法。该方法的核心在于通过设计双向置换操作,生成多样化的训练样本,从而提高模型的一致性学习能力和性能。

在ABD方法中,首先针对未标记数据设计了基于可靠预测置信度的双向补丁置换。具体而言,对于每个未标记的图像,模型会先对其进行预测,并根据预测结果的置信度将图像划分为可靠区域和不可靠区域。随后,在可靠区域内选择具有高置信度的补丁,并在不可靠区域内选择具有低置信度的补丁进行置换。这种双向置换操作有助于抑制不可控区域的影响,同时保留输入扰动对模型训练的积极作用。

逆置信度双向置换操作

此外,为了进一步增强模型对潜在不可控内容的学习能力,研究者们还提出了针对标记图像的逆置信度双向置换操作。对于每个标记图像,模型同样会先对其进行预测,并根据预测结果的置信度将图像划分为高置信度区域和低置信度区域。然后,在高置信度区域内选择具有低置信度的补丁(即相对不可靠的补丁),在低置信度区域内选择具有高置信度的补丁(即相对可靠的补丁)进行置换。这种逆置信度双向置换操作能够生成包含更多不可靠信息的样本,从而促使模型学习如何更好地处理这些潜在的不可控内容。

通过这两种置换操作,ABD方法能够生成多样化的训练样本,这些样本不仅包含了原始的图像信息,还引入了额外的扰动和不确定性。这些扰动和不确定性有助于模型在训练过程中学习到更加鲁棒和泛化的特征表示,从而提高其在一致性学习任务中的性能。

QuadMamba

Xie F, Zhang W, Wang Z, et al. QuadMamba: Learning Quadtree-based Selective Scan for Visual State Space Model[J]. arXiv preprint arXiv:2410.06806, 2024.

MemSAM

Deng X, Wu H, Zeng R, et al. MemSAM: Taming Segment Anything Model for Echocardiography Video Segmentation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2024: 9622-9631.

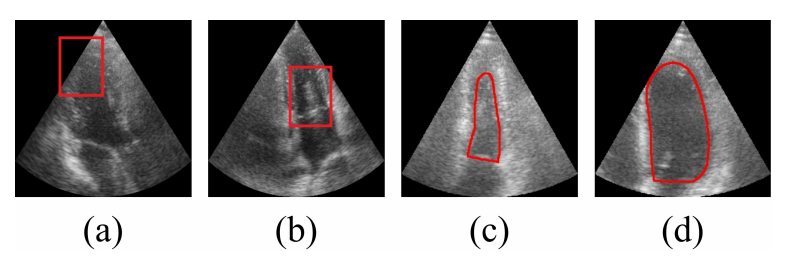

引言

根据世界卫生组织(WHO)的统计,心血管疾病是全球死亡的主要原因。超声心动图是评估心血管功能的重要而独特的工具。由于其便携性、低成本和实时性,超声心动图通常被用作临床实践中的一线检查方法。然而,超声心动图通常需要经验丰富的医生进行手动评估,评估质量严重依赖于医生的专业知识。因此,手动评估之间和观察者之间的差异往往很大。此外,评估需要手动跟踪心室大小,这既费力又费时,而且容易出错。在这方面,临床实践非常需要自动化评估方法

超声心动图评估和诊断通常基于对射血分数和心室容积的解释,这需要从超声心动图视频中准确分割出左心室心内膜等关键结构。然而,自动超声心动图分割一直是一项具有挑战性的任务。

首先,如图 1 (a,b) 所示,由于超声成像的限制,有很多不利因素影响超声心动图视频的质量,例如低信噪比、斑点噪声、边缘丢失以及由致密肌肉和肋骨等结构引起的阴影,难以识别关键解剖结构的边界。其次,视频内和视频之间的心脏结构形状和尺度变化很大(见图 1 (c,d))。最后,超声心动图视频的注释是一项劳动密集且耗时的工程,因此医生通常只注释收缩末期和舒张末期帧。最后,我们必须对注释有限且稀疏的超声心动图视频进行分割。

近年来,许多深度学习方法被提出用于超声心动图视频分割,但由于超声视频质量低、标注有限,这些方法仍然无法取得令人满意的效果。最近,一种大型视觉模型——Segment Anything Model (SAM) 被提出并在许多自然图像分割任务中取得了显著的成功。

一些研究人员试图将其应用于医学图像分割任务,以利用 SAM 强大的表征能力来缓解训练样本不足的问题。然而,这些研究大多集中在二维图像上,如何将 SAM 应用于医学视频分割仍是一项尚未探索且具有挑战性的任务。将 SAM 直接应用于视频会忽略时间线索,并可能导致时间不一致的分割。例如,如图 1 所示,快速变化的超声心动图视频在目标物体的形状和尺度上存在明显的时间不连续性。此外,大量斑点噪声和伪影造成的边界模糊将极大地阻碍 SAM 释放其表征能力。

在本文中,我们通过将 SAM 应用于医学视频提出了一种新颖的超声心动图视频分割模型,与自然视频相比,医学视频具有一些独特的特征。我们模型的核心技术是一种时间感知和抗噪声的提示方案。

具体来说,我们使用包含空间和时间信息的时空记忆来提示当前帧的分割,因此我们将提出的模型称为 MemSAM。在提示过程中,携带时间线索的记忆会逐帧顺序提示视频分割。同时,随着记忆提示传播高级特征,它避免了由掩码传播引起的错误识别问题并提高了表示一致性。为了应对斑点噪声的挑战,我们提出了一种记忆强化机制,该机制利用预测的掩码来提高记忆质量,然后再进行存储。我们在 SAMUS(一种基于 SAM 的医学基础模型)上构建了我们的模型,这使我们的模型更适应医疗数据。最后,我们在两个公开可用的数据集上进行了广泛的实验。我们的贡献可以总结如下:

- 我们提出了一种基于 SAM 的新型超声心动图视频分割模型。我们模型的核心组件是一种新的提示方法,它能够提供空间和时间线索,以提高表示一致性和分割准确性。

- 我们进一步提出了记忆强化模块,在存储记忆之前对其进行增强,从而减轻记忆提示过程中斑点噪声和运动伪影的不利影响。

- 我们在两个公共数据集上对我们的方法进行了广泛的评估,与现有模型相比,我们的模型表现出了最先进的性能。特别是,我们的模型在注释有限的情况下实现了与完全监督方法相当的性能。

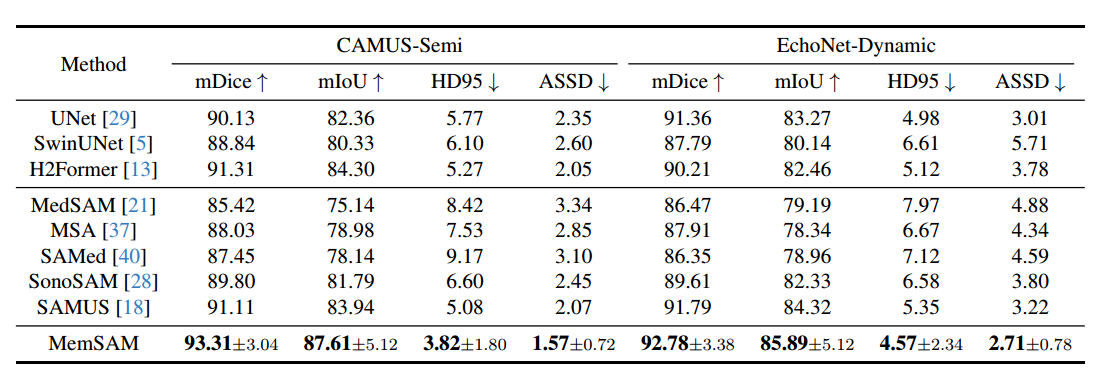

实验

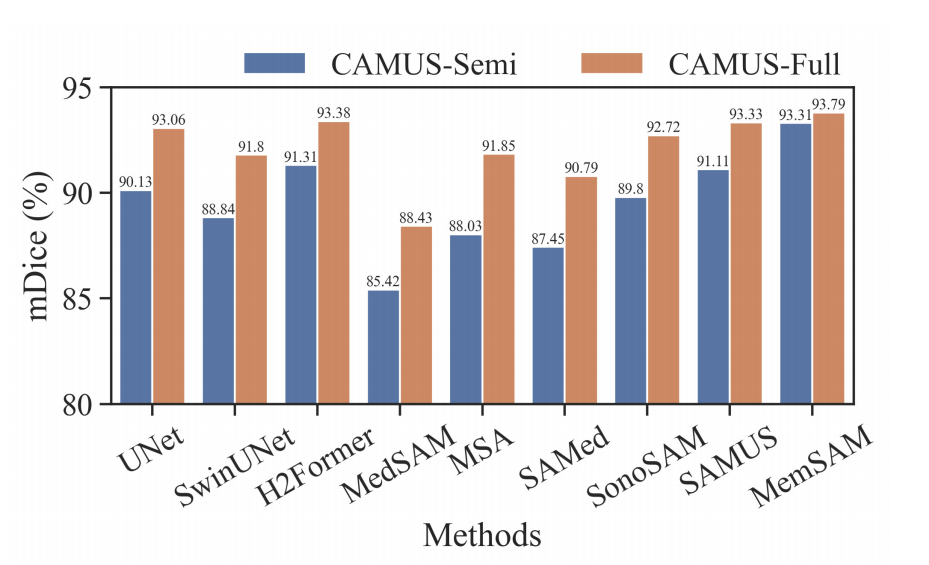

我们在两个广泛使用的公开超声心动图数据集 CAMUS 和 EchoNet-Dynamic 上评估了我们的方法。

CAMUS 数据集包含 500 个案例,其中包括 2D 心尖双腔和心尖四腔视图视频。CAMUS 为所有帧提供注释。

EchoNet-Dynamic 数据集包含 10,030 个 2D 心尖双腔视图视频。每个视频以积分的形式提供左心室的面积。仅标记收缩末期和舒张末期。

为了全面评估我们的方法在半监督视频分割中的有效性,CAMUS 数据集被改编为两个变体:CAMUS-Full 和 CAMUS-Semi。CAMUS-Full 在训练期间使用所有帧的注释,而 CAMUS-Semi 仅使用舒张末期 (ED) 和收缩末期 (ES) 帧的注释。在测试期间,这两个数据集都使用完整的注释进行评估。我们从数据集中均匀采样视频,将它们裁剪为每帧 10 帧。裁剪确保 ED 帧是第一帧,ES 帧是最后一帧,分辨率调整为 256×256。对于 CAMUS 数据集,我们按 7:1:2 的比例将其分为训练集、验证集和测试集,而我们对 EchoNet-Dynamic 数据集使用原始分割。

我们采用了广泛使用的指标,例如平均 Dice 系数 (mDice) 和平均并集 (mIoU) 进行分割评估,以及豪斯多夫距离-95% (HD95) 和平均对称表面距离 (ASSD)。我们还报告了这些指标的标准差。此外,我们还报告了左心室射血分数 (LVEF) 的三个统计指标。我们根据 CAMUS 数据集中提供的辛普森双平面圆盘方法 (SMOD) 估计预测 LVEF。

请注意,不同的实施方法会对最终的 LVEF 结果产生重大影响。SMOD 从心尖二腔和四腔视图的舒张末期和收缩末期时间实例估计 LVEF。与辛普森的单平面规则相比,SMOD 的估计解决方案更准确、更可靠。对于预测和真实 LVEF,我们计算皮尔逊相关系数 (corr)、平均偏差 (bias) 和标准误差 (std)。

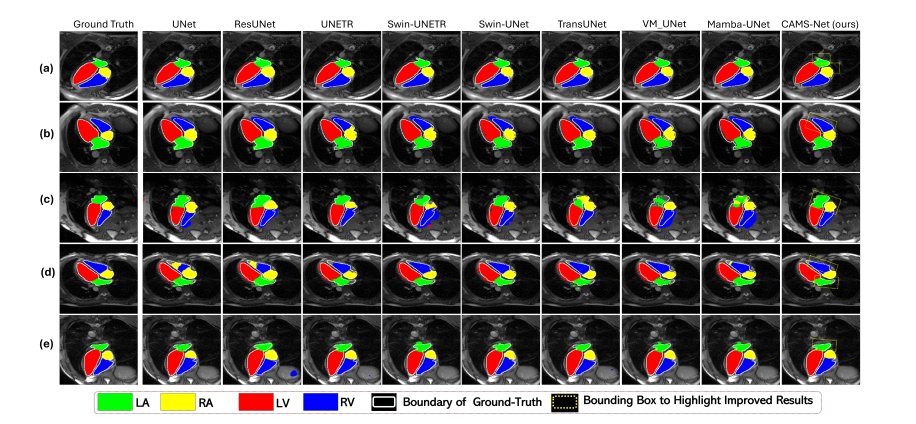

与最先进方法的比较

我们广泛选取了不同类型的比较方法,包括传统图像分割模型和医学基础模型。三种传统图像分割模型分别为基于CNN的UNet、基于Transformer的SwinUNet和CNN-Transformer混合的H2Former。医学适应的SAM模型包括MedSAM、MSA、SAMed、SonoSAM和SAMUS。其中SonoSAM和SAMUS专注于超声图像。

定量比较。 定量比较结果如表 1 所示。在这些最先进的方法中,H2Former 和 SAMUS 在两个数据集上表现相对较好,分别得益于 CNN-Transformer 架构和超声图像优化。然而,如果不利用稀缺注释下视频的时间属性,这些模型仍然落后于我们的方法。实验验证了我们的方法在有限的注释下实现了最先进的性能。

为了进一步评估我们的方法,我们在 CAMUS-Semi 和 CAMUS-Full 数据集上以相同的设置对其进行了比较。结果如图 5 所示。可以看出,UNet 和 H2Former 等传统方法以及 SonoSAM 和 SAMUS 等超声波专业方法在完整注释的情况下恢复了不错的结果。虽然我们的方法从半监督到全监督设置都有边际收益,但它在这两种情况下仍然优于其他竞争对手。值得注意的是,医学基础模型需要在完全监督下逐帧提示,而我们只需要一个点提示。实验验证了我们的方法使用更少的外部提示实现了与稀疏标签的完整注释相当的性能。

结论

在本文中,我们提出了一种用于超声心动图视频分割的新型半监督视频分割框架,旨在有效地将 SAM 扩展到视频领域,并在有限的注释和提示下实现与全监督相当的性能。然而,当初始帧图像非常差时,我们的方法会导致整个视频序列无法准确分割。未来的研究可以研究实现更稳健初始化的技术,并在更多领域测试我们的方法的有效性,并可以进一步探索降低计算成本和轻量化模型的方法。

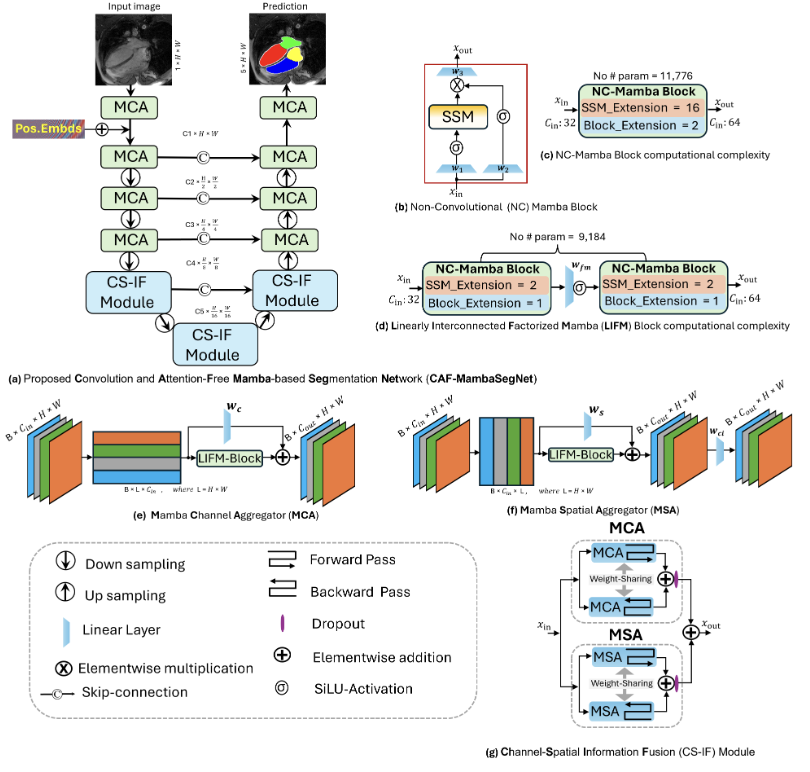

CAF-MambaSegNet

2D 不好改,之后再看

提出了一种名为CAF-MambaSegNet的无卷积和自注意力的语义分割网络,通过设计Mamba-based Channel Aggregator和Spatial Aggregator以及Linearly Interconnected Factorized Mamba (LIFM) Block,展示了在心脏图像分割中不依赖传统CNN和Transformer的方法,旨在减少计算复杂度和参数数量。

创新点:

1.提出了无卷积和自注意力的CAF-MambaSegNet网络,创新地使用Mamba-based Channel Aggregator和Spatial Aggregator进行特征提取。

2.引入了Linearly Interconnected Factorized Mamba (LIFM) Block,以减少计算复杂度并增强决策函数。

3.展示了在心脏图像分割任务中,线性复杂度和减少参数数量的方法可以取得与现有方法相当的效果。

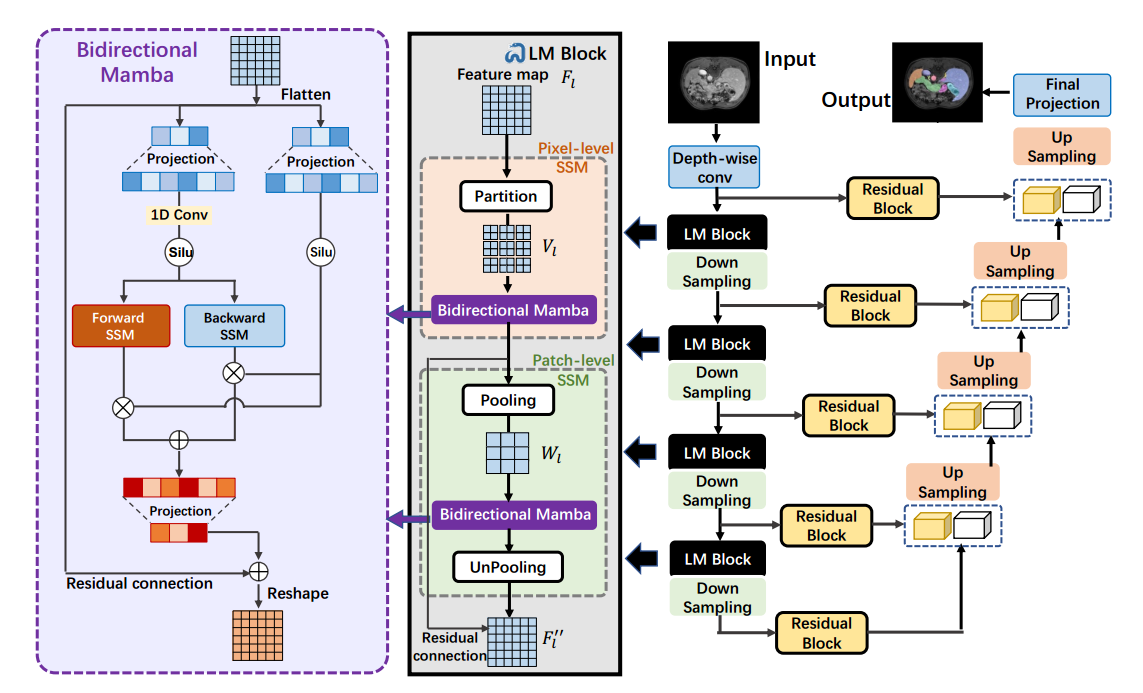

LKM-UNet

可以用于3D,但不好改

作者提出了一种新的基于 Mamba 的 UNet 模型(LKM-UNet),用于 2D 和 3D 医学图像分割

摘要

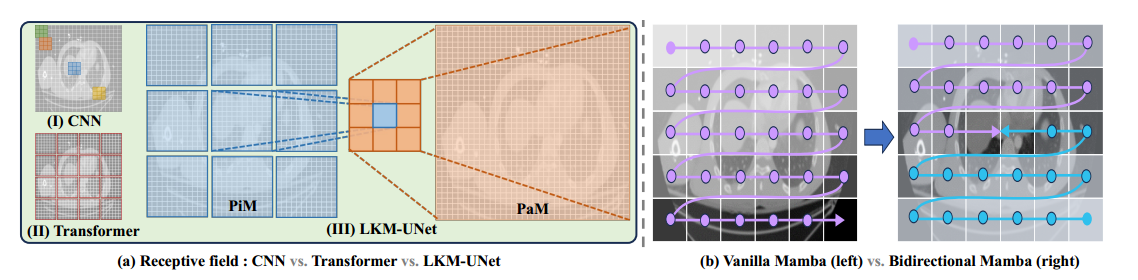

LKM-UNet 的一个区别特征是其使用大型 Mamba 内核,与基于小内核的 CNN 和 Transformers 相比,在局部空间建模方面表现出色,同时保持了与二次复杂性的自注意力相比的优越效率。此外,我们设计了一种新颖的层次化和双向 Mamba 块,以进一步增强 Mamba 对视觉输入的全局和邻域空间建模能力。

方法

LKM-UNet

除了常见的 UNet 组成,包括深度可分离卷积、编码器下采样层、解码器上采样层和跳跃连接外,LKM-UNet 通过在编码器中插入提出的大内核 Mamba(LM)块来改进 UNet 的结构。

在每个阶段之后,生成的特征图 被编码为 (2C,D/2,H/2,W/2)

LM-block

LM 块是用于进一步空间建模每个阶段不同尺度的特征图的核心组件。与之前使用 CNN 进行局部像素级建模和 Transformer 进行长距离块级依赖性建模的方法不同,LM 块可以同时完成像素级和块级建模,得益于 Mamba 的线性复杂性。更重要的是,较低的复杂性允许设置更大的内核(窗口)以获得更大的感受野,这将提高局部建模的效率.

在大内核分割策略下,感受野被扩大,模型可以获得更多局部像素的细节。然而,图像被分割成非重叠的子内核。因此,我们需要一个机制来实现不同子内核之间的通信,以进行长距离依赖性建模。块级 SSM(PaM)。我们引入了一个块级 SSM 层,以在不同的子内核之间传递信息.

与基于前向扫描方向 SSM 层的原始 Mamba 块不同,LM 块中的每个 SSM 层(包括 PiM 和 PaM)都是双向的。图 2(b) 显示了差异。在原始 Mamba 中,作为一个连续模型,一些信息遗忘发生在早期进入的元素上,而最后进入 Mamba 的元素将保留更多的信息。因此,具有单一扫描方向的原始 Mamba 将更多地关注后部块,而不是通常包含更多器官和病变的特征图的中心区域。为此,我们提出了一个双向 Mamba 结构,通过同时进行前向和后向扫描并叠加输出结果。BiM 有两个优点。首先,模型可以更多地关注图像中心区域的信息块,而不是角落区域。其次,对于每个块,绝对位置信息和与其他块的相对位置信息可以被网络很好地建模。

Deformable Attention

Xia Z, Pan X, Song S, et al. Vision transformer with deformable attention[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2022: 4794-4803.

Serp-Mamba

Wang H, Chen Y, Chen W, et al. Serp-Mamba: Advancing High-Resolution Retinal Vessel Segmentation with Selective State-Space Model[J]. arXiv preprint arXiv:2409.04356, 2024.

蛇形交织自适应(SIA)扫描机制和模糊度驱动的双重重校准(ADDR)模块

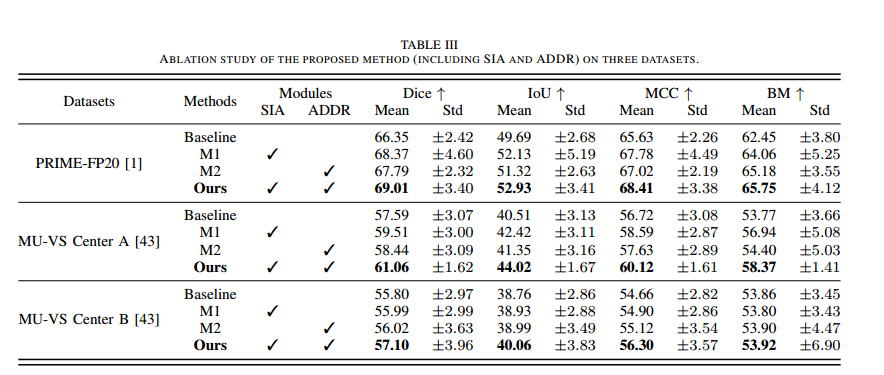

消融实验

(i)基线:我们采用经典的U形U-Mamba骨干网络作为基线模型;(ii)M1:我们包括SIA扫描机制,并且没有ADDR模块,以测试SIA是否能够使Mamba块在沿沿着可学习的血管路径扫描之后提高分割的准确性;(iii)M2:我们去除了SIA扫描机制,并在M1的基础上加入了ADDR模块,以验证ADDR在解决类别不平衡问题和增强血管连续性; (iv) ours:我们的Serp-Mamba包括SIA扫描机制和ADDR模块。

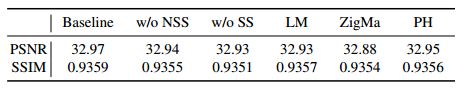

MaIR

Li B, Zhao H, Wang W, et al. MaIR: A Locality-and Continuity-Preserving Mamba for Image Restoration[J]. arXiv preprint arXiv:2412.20066, 2024.

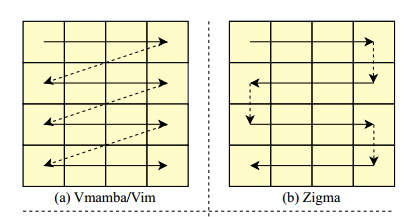

消融对比几种扫描方式

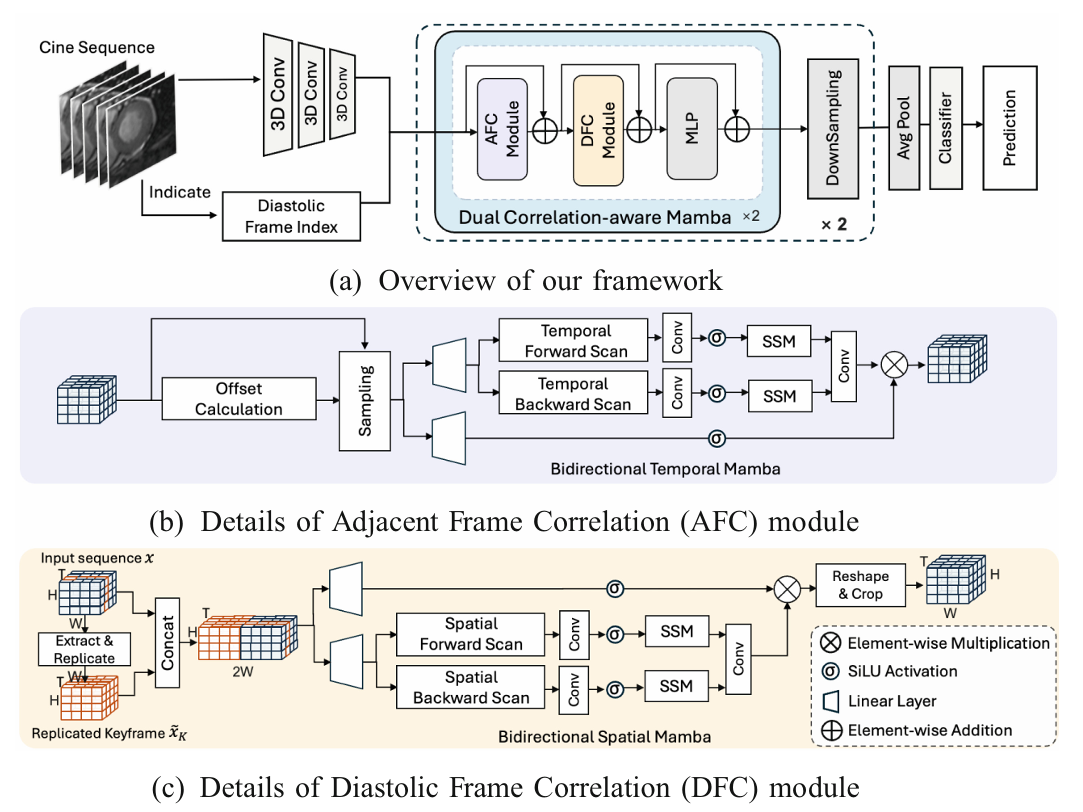

Dual Correlation-aware Mamba

Dual Correlation-Aware Mamba for Microvascular Obstruction Identification in Non-contrast Cine Cardiac Magnetic Resonance

该研究提出双相关感知 Mamba(DCM)方法,实现非对比 cine 心脏磁共振(CMR)的微血管阻塞(MVO)识别,解决现有方法运动特征提取不足和忽视区域壁运动异常(RWMA)的问题,性能优于现有竞品,为肾损伤患者提供了可行的非对比检测方案。

研究背景与核心问题

- MVO 是急性心肌梗死的关键预后因素,晚期钆增强(LGE)-CMR 是诊断金标准,但不适用于占比 20% 的肾损伤患者。

- 非对比 cine CMR 可捕捉心脏周期运动,有望替代 LGE,但 MVO 在单帧不可见,需分析多帧运动特征。

- 现有方法存在两大局限:隐式建模运动动态导致特征提取不充分,忽视 MVO 引发的 RWMA 这一关键诊断依据。

核心方法设计

- 整体框架:通过 3D CNN 提取 cine 序列特征,经两阶段 DCM 块(含 AFC 和 DFC 模块)增强运动特征,最终通过平均池化和分类器输出 MVO 检测结果。

- Adjacent Frame Correlation(AFC)模块:计算相邻帧间相关性,预测像素位移偏移量,显式建模心脏运动动态,结合双向时间 Mamba 聚合特征。

- Diastolic Frame Correlation(DFC)模块:以舒张期帧为全局参考,学习其与其他帧的相关性,突出 RWMA,通过双向空间 Mamba 聚合运动信息。

- 损失函数:采用交叉熵损失 + 均值平方误差损失(权重 0.05),结合粗粒度掩码正则化优化训练。

实验结果

- 数据集:816 例急性心肌梗死患者数据,按训练集(550 例)和测试集(266 例)随机划分,以 AUC、特异性、准确率等为评价指标。

- 性能对比:DCM 的 AUC 达 0.7687,在各项指标上均超过 VST、CGMR 等现有方法,且参数量(39.91M)更具优势。

- 消融实验:AFC 和 DFC 模块均对性能有显著贡献;舒张期帧是最优参考帧;两阶段框架结构实现最佳性能;可学习偏移量和最优窗口半径([2,1])提升了运动建模效果。

结论与展望

- DCM 通过显式建模运动动态和参考舒张期帧引导学习,有效提升了非对比 cine CMR 的 MVO 识别能力。

- 未来将进一步优化 MVO 轮廓描绘,并探索其与其他引发心肌异常的心脏病变的鉴别方法。

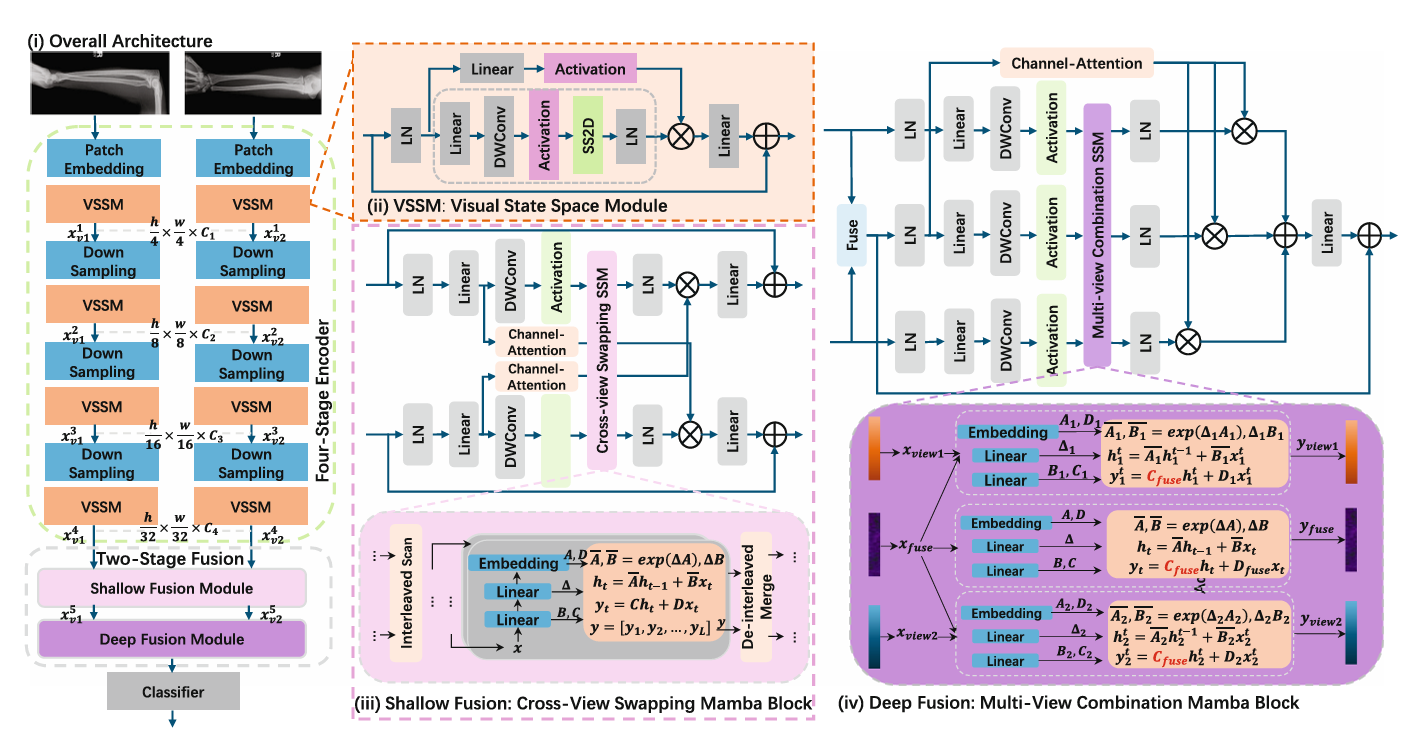

XFMamba

XFMamba 是一款基于状态空间模型(Mamba)的纯 Mamba 跨融合架构,专为多视图医学图像分类设计,在 MURA、CheXpert、CBIS-DDSM 三大数据集上表现优于现有卷积和 Transformer 基方法,兼顾分类精度与计算效率。

核心贡献

- 首次将 Mamba(状态空间模型)成功应用于多视图医学图像分类任务。

- 提出两阶段 Mamba 融合机制,高效提取并无缝整合多视图信息。

- 经三大不同临床场景数据集验证,确立了 Mamba 在多视图医学成像领域的性能基准。

架构设计

-

四阶段多尺度编码器:以 VMamba 为骨干,含两个并行分支,分别处理两种不同视图的输入图像。通过图像分块、三次下采样和视觉状态空间模块(VSSM),提取四级多尺度特征。

-

两阶段融合模块:

-

浅层融合(CVSM 块):通过跨视图交织机制交换局部特征,结合通道注意力重加权,增强视图间局部关联。

CVSM 的核心创新是基于通道掩码的跨视图交织机制,解决 “局部跨视图特征关联捕捉” 与 “计算效率” 的矛盾:

- 设计二进制通道掩码

M(C)(Eq.4):对两个视图的深层特征(如Xv1⁴、Xv2⁴),按通道奇偶性进行 “选择性交织”—— 偶数通道替换为另一视图的对应通道,奇数通道保留本视图通道。这种方式无需额外参数或复杂计算,即可实现 “视图间局部特征交换”,避免传统交叉注意力的高计算成本。 - 引入 “交叉通道注意力重加权”:复用 Squeeze-and-Excitation(SE)机制,但创新地将 “单视图自注意力” 改为 “跨视图互注意力”—— 用视图 v1 的全局上下文注意力来调整视图 v2 的通道权重,反之亦然。这一设计确保 “融合后的特征能优先保留两视图中与病灶相关的关键信息”,而非简单平均

- 设计二进制通道掩码

-

深层融合(MVCM 块):聚合浅层融合输出,通过多视图选择性扫描和融合乘法机制,生成全局整合的融合特征。

CVSM 仅解决 “局部特征交互”,而 MVCM 针对 “全局多视图信息整合” 设计,核心创新在于多分支协同与状态空间模型(SSM)的定制化改造:

- 三分支输入设计:将 CVSM 输出的两视图特征(Xv1⁵、Xv2⁵)与 “两视图直接融合特征” 作为三个并行分支,同时输入 MVCM。这种设计避免 “单一分支丢失视图特异性信息”,确保融合时既保留单视图细节,又能捕捉全局关联。

- 定制化多视图 SSM 模块:改造传统 SSM 的 “单序列处理” 为 “多序列协同处理”—— 引入融合分支的系统矩阵

C_fuse,用其解码两个单视图分支的隐藏状态(Eq.5),即 “用全局融合特征的上下文来引导单视图特征的优化”(🔶1-46、🔶1-49)。这一改造让 SSM 从 “单视图长距离依赖建模” 升级为 “多视图全局关联建模”,确保融合特征的整体性。 - 融合乘法机制:对归一化后的单视图特征与融合特征进行乘法交互,自适应学习 “融合特征对单视图特征的增益权重”,而非传统的简单加法或拼接(🔶1-50)。这种方式能动态强化 “两视图共识的关键特征”(如病灶区域),抑制 “视图特异性噪声”(如成像 artifacts)

-

实验验证

- 数据集与设置:覆盖肌肉骨骼 X 线、胸部 X 线、乳腺钼靶三大场景,统一将图像 resize 为 224×224,基于 PyTorch 训练,提供 tiny、small、base 三种模型变体。

- 性能表现:small 和 base 变体在所有数据集上 AUROC 值最高;tiny 变体参数更少(39.29M),计算量(FLOPs)最低,仍在 MURA、CheXpert 数据集上优于多数对比方法。

- 消融实验:两阶段融合模块缺一不可,移除后性能下降 0.4%~0.92%;多视图融合比单视图(提升 1.03%~2.17%)、早期 / 晚期融合(提升 0.92%~0.94%)更有效。

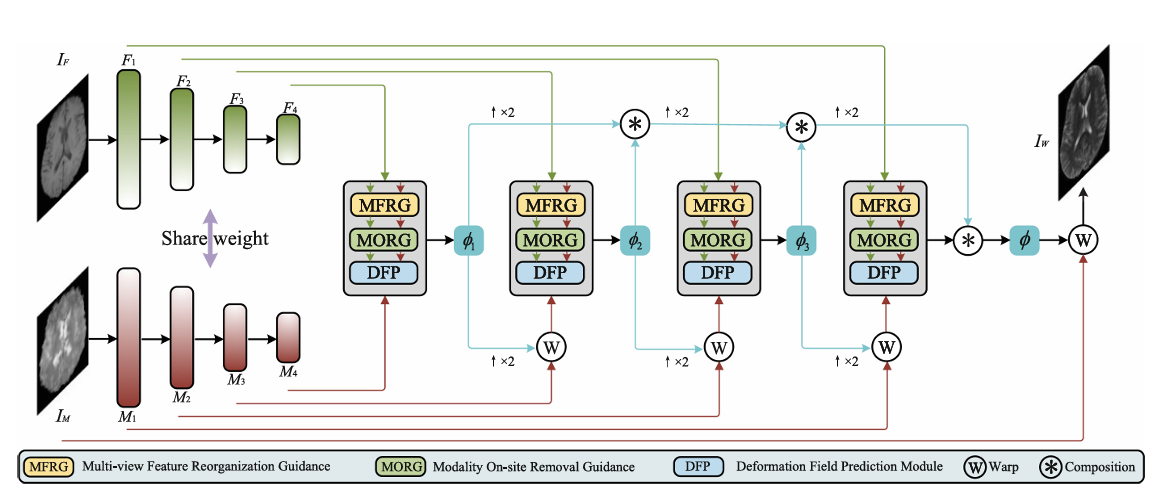

DGMIR

DGMIR: Dual-Guided Multimodal Medical Image Registration Based on Multi-view Augmentation and On-Site Modality Removal

整体结构

- 编码器为四阶段架构,输出两组多尺度特征图;解码器采用粗到细策略,每阶段整合 MFRG 和 MORG 模块。

- 形变场预测采用迭代融合策略,结合前一阶段子形变场与当前阶段输出,保证连续性。

核心模块原理

- MFRG:融合特征通道的均值、最大值统计信息,计算模态间交叉相关性和模态内自相关性,通过校准因子自适应增强有效特征。

- MORG:结合普通卷积与空洞卷积提取多感受野特征,通过均值卷积分离模态特征并移除,保留结构信息。

TM-Mamba

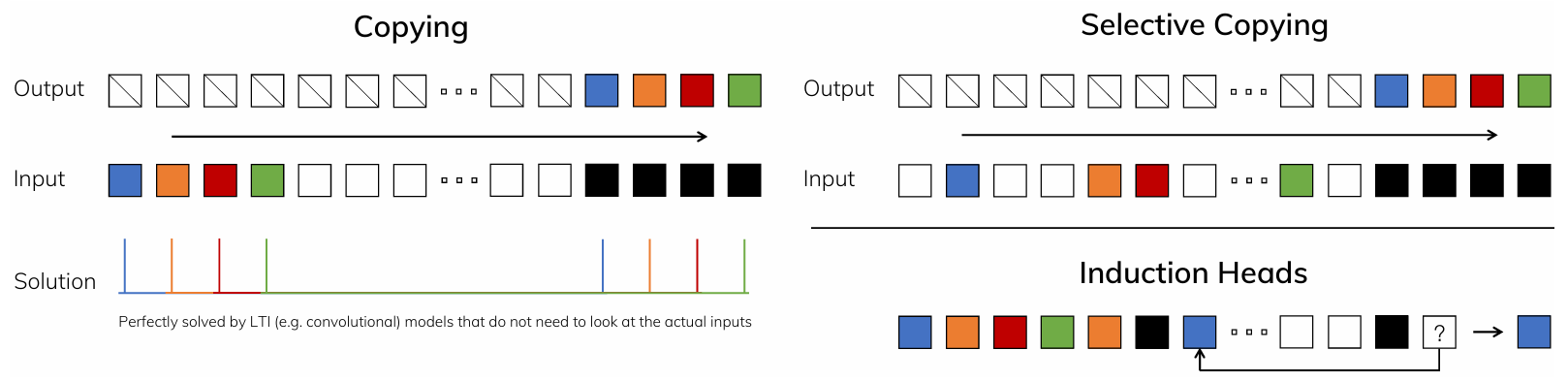

mamba的选择机制

它用的是 Mamba(状态空间模型),但做了一个关键改造:

👉 Mamba 里有一套“选择机制(selection mechanism)”

👉 原来:只由当前动作决定

👉 现在:由「动作 + 文本」共同决定

这篇论文不是“用文本来对齐动作”, 而是“用文本来控制模型在时间维度上的记忆策略”。

- 文本真正参与了“时间建模”,怎么在时间上传播信息,本身就由文本决定

- 文本不是逐词对齐,也不是注意力暴力匹配,没有token × frame 的巨大 attention,只有文本作为全局条件,控制“记 or 不记”